先端研の研究領域

研究事例

深層学習による光学衛星画像からの浸水域自動抽出技術開発

戦略的イノベーション創造プログラム「国家レジリエンス(防災・減災)の強化」

はじめに

内閣府が推進する戦略的イノベーション創造プログラム(SIP)第2期の課題の1つが「国家レジリエンス(防災・減災)の強化」です。アジア航測では中部大学を中心に研究が進められているサブテーマ「浸水状況把握および洪水氾濫シミュレーション」の一員として研究開発に参加しています。

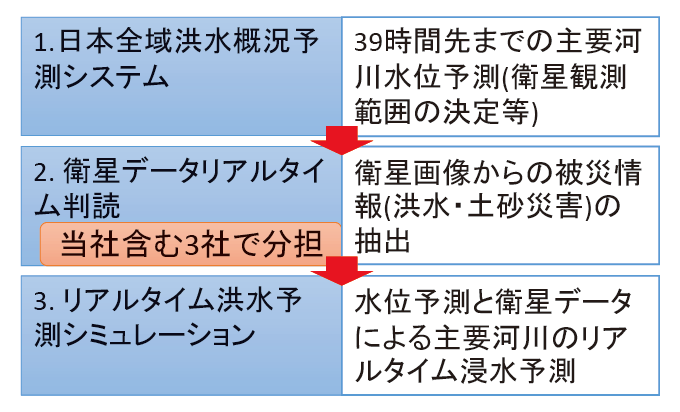

サブテーマは、3つのパートから構成されており(図1)、1つ目は台風や梅雨前線による洪水予測を最大39時間先まで予測し衛星観測の対象を絞り込む日本全域洪水概況予測システム、2つ目は観測された衛星データから浸水域を自動判読する衛星データリアルタイム判読、3つ目は衛星で得られた被災範囲をもとにリスク判定を行うリアルタイム洪水予測シミュレーションです。

当社は、2つ目の取組の中で、光学衛星画像の観測後2時間以内の被災状況把握を担当しています。

本取組は、災害情報に関する空間データ規格の統一、一元化とグローバルなデファクトスタンダードを先導する狙いで、2018年から5ヶ年計画で実施中です。

衛星データリアルタイム判読(深層学習による浸水域の自動判読)

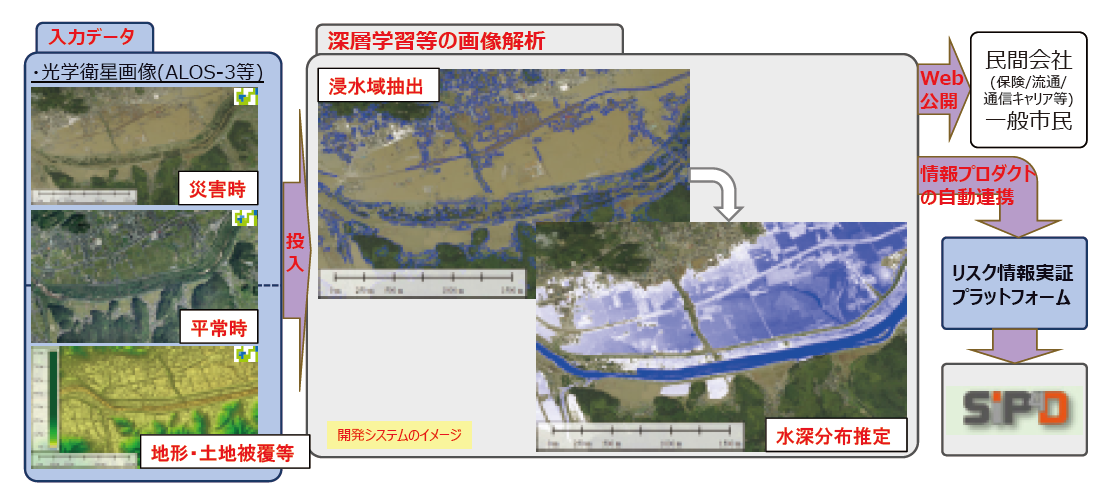

アジア航測が担当する衛星データリアルタイム判読では、光学衛星画像による浸水域の自動判読および、浸水深分布の推定を行います(図2)。解析に用いた衛星データは表1に示すとおりです。2020年度に打ち上げが予定されている宇宙航空研究開発機構の先進光学衛星(ALOS-3)、欧州宇宙機関のSentinel-2、DigitalGlobe社やAIRBUS DEFENCE and SPACE社の商用衛星等、幅広い光学衛星画像を想定しており、様々な衛星データを活用することにより被災情報を迅速に把握する狙いがあります。

災害時の衛星観測から地上へのデータ転送・画像生成までに要する時間は現在1時間、後続のリアルタイム洪水予測シミュレーションに要する時間を考慮すると、浸水域判読と浸水深分布推定に残された時間は30分間未満です。判読者による作業には限界があるため、様々な衛星データを自動で迅速に解析する新しい手法の開発が必要となります。

| 衛星 | 画素寸法(m) | 観測幅 | 機数 |

|---|---|---|---|

| 先進光学衛星(ALOS-3) | 0.8m | 70km | 1 |

| Sentinel-2 | 10 ~ 60m | 290km | 2 |

| WorldView-2,3 | < 0.5m | 13-16km | 2 |

| Pleiades | < 0.5m | 20km | 2 |

| SPOT-6,7 | 1.5m | 60km | 2 |

深層学習の活用

衛星データ解析により浸水域および浸水深を探る技術としては、災害前後の2時期のデータによる変化の抽出、や複数バンド(波長)を用いた手法がこれまでに多数考案されており、一定の成果を上げています。

しかしいずれの手法も画像間の位置合わせや、観測日の気象条件等に合わせた補正処理、解析対象に合わせたアルゴリズムの選択といった点で人手による処理・判断が必要であり、自動化にあたっての課題となっています。

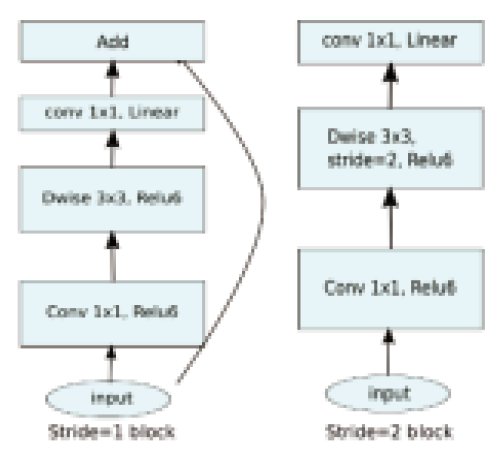

この課題に対応するため、本取組では近年開発が進んでいる深層学習の適用を試行しました(図3、図4)。深層学習のモデルにはMobileNetV2を利用しており、大規模な計算設備を必要としないコンパクトなシステムを目指しています。過去の水害を観測した衛星データ(H30年7月豪雨(真備)、H27年9月関東東北豪雨(常総市、大崎市))を判読し、学習用データ(512×512画素単位で全1,553画像)として深層学習を実施することで、災害後の衛星データから浸水範囲を抽出に概ね成功していることが分かります。浸水域の抽出精度は判読者の結果と比較して85%程度です。

現時点では学習用データが不十分なことも有り、判読作業者の精度には達していませんが、学習用データの増強、近赤外バンドや地形情報の追加等により更なる改善が見込まれます。

画像ⓒAirbus DS 2019、右:青色が浸水域、赤色が陸域、モデルは

MobileNetV2を利用、2019年台風19号阿武隈川)

おわりに

本技術は、昨年度開発済みの「衛星監視カメラによる広域土砂移動域の自動抽出」と組み合わせることにより、総合的な防災情報提供システムへと進化していく予定です。本研究を実施するにあたり、内閣府、防災科学技術研究所、中部大学、日本測量技術調査協会および宇宙航空研究開発機構のご指導をいただきました。ここに御礼申し上げます。